1. Exception in thread “main” java.io.IOException: No space left on device

http://www.ys-network.info/?p=6025

Chạy thử lệnh df -h để kiểm tra thì thấy đúng là có 1 ổ full thật (/)

Mình thử cho thư mục /tmp ra Ram để giảm tải, làm theo hướng dẫn sau:

http://unix.stackexchange.com/questions/55773/move-tmp-to-ram

Kết quả là vẫn thế @.@ (hoặc thay đổi ko đáng kể)

Mình phải xoá 1 folder hadoop phiên bản cũ để lấy được 5% bộ nhớ.

Chạy thử câu lệnh sau thì phát hiện /usr/share chiếm quá nhiều bộ nhớ

du -h / -d 1 | sort -nr

Vẫn chưa biết cách nào để giảm bộ nhớ sử dụng trên VM.

Tạm thời chạy được nhờ có 5% bộ nhớ trống.

-> Mới phát hiện ra lỗi này có thể do mình đã thực hiện câu lệnh sau:

strm00:~$hadoop jar spatialhadoop-2.2.jar generate output mbr:0,0,100,100 size:1.gb shape:point -overwrite

Câu lệnh này đã sinh ra 1 point độ lớn 1GB làm chiếm hết bộ nhớ. Đến h mình vẫn chưa biết làm thế nào để giải phóng bộ nhớ, tuy nhiên rút kinh nghiệm mình đã chỉnh 1GB thành 1MB ^^

2. could only be replicated to 0 nodes, instead of 1

Nhờ đọc lại kiến thức về hdfs mình mới thấy lỗi này là do datanode chưa được start.

Check log ở slave để biết tại sao lại lỗi

– Đầu tiên là lỗi ko phân quyền cho folder -> phân quyền

– Lỗi ko hiểu domain localhost.localdomain -> thêm vào /etc/hosts (h vẫn ko hiểu sao nó nhất quyết đọc ra cái domain này)

– H đang gặp lỗi ko connect với master được 😦

Update 21.08.2014

– Mình nghĩ lỗi là do chưa set port 9000 ở iptables, mình thử thêm 10.10.0.0/24 với port 9000 vào nhưng không được.

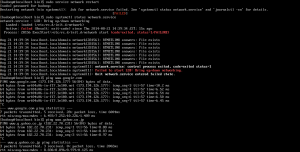

– Sau đó mình nghĩ có thể NETMASK của mình ko chuẩn, mình nghĩ nó phải la 255.255.255.0 chứ ko phải 255.255.0.0 nên mình thử đổi trong file eth0

vi /etc/sysconfig/network-scripts/ifcfg-eth0

Sau khi thêm NETMASK vào thì restart network

service network restart

Kết quả: lỗi 😦 Kỳ lạ là mình vẫn ping được 😦

Sáng nay thấy 1 cái bug report cho Centos 7, chưa thấy có revised version

http://bugs.centos.org/view.php?id=7445

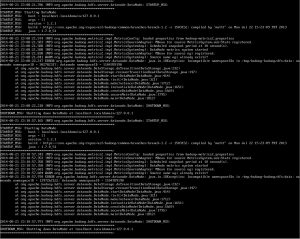

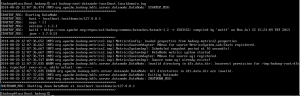

Đột nhiên bị lỗi

“java.io.IOException: Incompatible namespaceIDs”

Cách xử lý: xoá file data trong thư mục /tmp/hadoop-hadoop/dfs/data, sau đó format lại namenode

※ Cần tìm hiểu tại sao lại bị lỗi này, vì ko phải lúc nào cũn format namenode được. Format sẽ làm mất hết dữ liệu

http://stackoverflow.com/questions/20883564/hadoop-connection-refused-on-namenode